Índice de contenidos

ToggleSin duda, las decisiones basadas en datos marcan la diferencia entre el éxito y pasar desapercibido. Los test A/B se han convertido en una herramienta imprescindible para CRO dentro del marketing digital. Gracias a ellos, las marcas pueden medir, comparar y optimizar sus estrategias con precisión, identificando qué versión de su página web, anuncio o correo electrónico ofrece mejores resultados.

El concepto me parece tan simple como poderoso: presentamos dos versiones (A y B) para determinar cuál genera mayor impacto. Sin embargo, detrás de esta aparente simplicidad se esconde toda una metodología que permite tomar decisiones fundamentadas, reducir el margen de error y maximizar el rendimiento de cada acción.

Desde NeoAttack, exploraremos qué es un test A/B, las tipologías más utilizadas, y las ventajas que aporta su implementación en estrategias de marketing. Además, veremos cómo realizarlos correctamente y qué errores evitar para obtener resultados realmente fiables.

Qué es un test A/B y por qué es clave en marketing digital

Dato mata relato. En marketing, las decisiones no deberían tomarse por intuición, sino por datos comprobados. Los test A/B se han convertido en herramienta esencial para validar hipótesis y optimizar resultados de manera continua.

Este tipo de pruebas permite medir de forma precisa el impacto de los cambios que realizamos en nuestras estrategias, evitando suposiciones y centrándonos en la evidencia. En un entorno donde cada clic cuenta, los tests A/B son el punto de partida de cualquier enfoque de marketing basado en datos.

Definición sencilla de test A/B

Un test A/B es un experimento controlado que compara dos versiones de un mismo elemento (la versión A y la versión B) para determinar cuál ofrece mejores resultados en relación con un objetivo concreto.

Por ejemplo, si una empresa quiere aumentar el número de clics en un botón de compra, puede crear dos versiones de su página:

- En la versión A, el botón es azul y dice “Comprar ahora”.

- En la versión B, el botón es verde y dice “Consíguelo hoy”.

Ambas versiones se muestran a diferentes grupos de usuarios durante un periodo determinado. Una vez que se recopilan suficientes datos, se comparan los resultados y se identifica cuál ha tenido un mejor desempeño (en este caso, una mayor tasa de clics).

En resumen, un test A/B sirve para tomar decisiones basadas en evidencia real, no en suposiciones.

Cómo funciona un test A/B paso a paso

Aunque la idea detrás del test A/B es simple, su efectividad depende de seguir un proceso metódico. A grandes rasgos, estos son los pasos básicos:

- Definir un objetivo claro:

Antes de lanzar un test A/B, es necesario tener claro qué se quiere mejorar: puede ser la tasa de conversión, el CTR, etc. - Formular una hipótesis:

Ejemplo: “Si cambio el color del botón de azul a verde, la tasa de clics aumentará porque el nuevo color destaca más”. - Seleccionar la variable a testear:

Lo ideal es cambiar solo un elemento a la vez para poder atribuir los resultados al cambio realizado. Puede ser un titular, un CTA, una imagen, un campo de formulario, etc. - Dividir la audiencia en dos grupos:

El grupo A verá la versión original (control) y el grupo B la versión modificada (variación). Ambos deben tener un tamaño similar y características comparables para que el test sea válido. - Lanzar el test y recoger datos:

Se deja correr la prueba durante un tiempo suficiente (dependiendo del tráfico y la muestra necesaria) para obtener resultados estadísticamente significativos: una confianza del 95 % es lo óptimo. - Analizar los resultados:

Una vez finalizado el experimento, se comparan las métricas clave y se determina qué versión obtuvo un mejor rendimiento. - Aplicar los aprendizajes:

Si la versión B supera a la A, se implementa el cambio en la campaña general. Si no hay diferencia significativa, se puede ajustar la hipótesis y realizar un nuevo test.

Ejemplos prácticos de uso

Ejemplo 1: Optimización de una landing page

Para una agencia de viajes online, detectamos que su página de destino tiene una tasa de conversión baja (2 %).

Decidimos realizar un test A/B cambiando el titular principal:

- Versión A: “Descubre el Caribe con un 20 % de descuento”.

- Versión B: “Tus vacaciones soñadas en el Caribe, ahora más cerca que nunca”.

Tras dos semanas, la versión B logra un aumento del 15 % en las reservas, demostrando que un mensaje más emocional conecta mejor con el público.

Ejemplo 2: Test A/B en email marketing

Lanzamos una campaña de email marketing para una tienda de moda para anunciar su nueva colección.

Realizamos un test A/B con dos asuntos distintos:

- Versión A: “¡Novedades exclusivas solo por tiempo limitado!”

- Versión B: “Nueva colección otoño-invierno: inspírate aquí 🍂”

El grupo que recibió la versión B mostró una tasa de apertura un 12% superior, por lo que adaptamos este tono más personal y visual en futuras campañas.

Ejemplo 3: Test A/B en anuncios de redes sociales

Probamos dos anuncios distintos en Meta Ads para una startup de tecnología:

- Versión A: un vídeo de un cliente mostrando las características del producto (UGC).

- Versión B: un carrusel de imágenes con las características del producto.

El resultado: el anuncio tipo vídeo (A) obtuvo un CTR un 25% mayor y un coste por clic un 18 % menor.

Conclusión: El contenido generado por usuarios (UGC) resultó más persuasivo que el carrusel de imágenes.

Estos ejemplos demuestran cómo un simple test A/B puede ofrecer insights valiosos sobre el comportamiento del usuario, ayudando a optimizar campañas y maximizar resultados. Lo importante no es solo hacer pruebas, sino aprender de cada una para mejorar continuamente.

Tipologías de test A/B más utilizadas

Repasamos los principales tipos de test A/B que se emplean en marketing y optimización digital.

Test A/B clásico

El test A/B es la forma más simple y común de prueba: se comparan dos versiones diferentes de un mismo elemento para determinar cuál funciona mejor frente a un objetivo específico.

Este tipo de prueba es ideal cuando quieres evaluar un único cambio —como un titular, un botón CTA o una imagen— y medir su impacto directo en los resultados (por ejemplo, conversiones o clics).

Aunque a veces se confunde con el término “split test”, en muchos contextos ambos se usan como sinónimos para describir comparaciones directas entre dos variantes

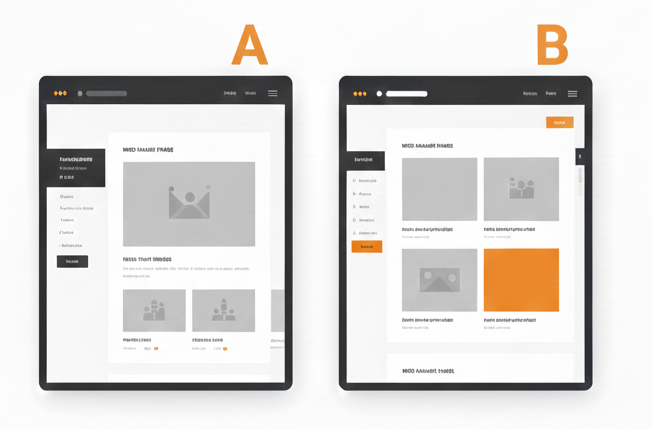

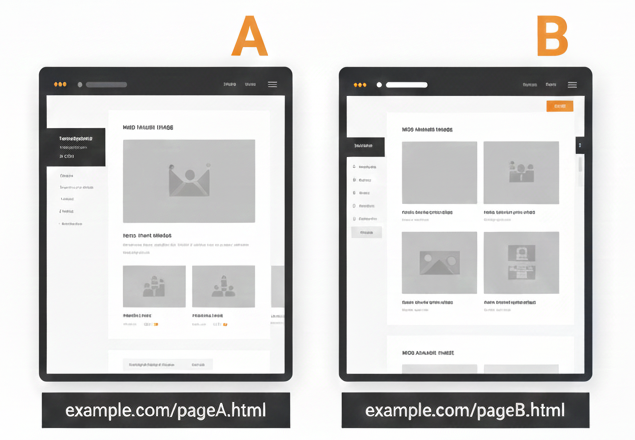

Split Test

Aunque a menudo se utiliza como sinónimo de test A/B, el split test puede referirse específicamente a pruebas en las que se comparan dos versiones totalmente distintas de una página o recurso completo, normalmente ubicadas en URLs diferentes.

Este enfoque es útil cuando el cambio no es solo un elemento aislado, sino todo un diseño o estructura alternativa (por ejemplo, una landing page completamente rediseñada frente a otra)

Test Multivariante

El test multivariante va un paso más allá: en lugar de probar solo dos versiones, combina múltiples variantes de varios elementos simultáneamente y evalúa cuál combinación funciona mejor.

Por ejemplo, si quieres evaluar distintas combinaciones de titular, imagen y CTA, el sistema crea automáticamente todas las versiones posibles con esas variaciones y analiza cuál combinación tiene mayor impacto.

Este enfoque es ideal cuando quieres entender interacciones entre múltiples cambios, aunque suele requerir más tráfico y datos para obtener resultados estadísticamente significativos que un test A/B tradicional.

Multi-Armed Bandit

El enfoque multi-armed bandit (o enfoque adaptativo) es una alternativa más dinámica a los tests A/B clásicos. En lugar de dividir tráfico fijo entre dos versiones durante todo el experimento, asigna gradualmente más tráfico a la versión que está mejor funcionando en tiempo real.

Esto permite que, a medida que una variante demuestra ser más eficaz, más usuarios la vean sin necesidad de esperar a que finalice el test completo, lo que puede acelerar los resultados y maximizar conversiones durante la propia prueba.

Este tipo de test es especialmente útil cuando el objetivo es maximizar los resultados actuales, en lugar de simplemente determinar cuál versión es mejor tras un periodo de experimentación.

Test A/A

El test A/A es una prueba particular donde ambas versiones son idénticas. Puede parecer extraño, pero su finalidad no es medir mejoras, sino verificar la configuración de la herramienta o el sistema de test.

Si tienes dos versiones exactamente iguales y los resultados muestran diferencias significativas, puede indicar un problema de configuración, sesgo en la muestra o errores en la recolección de datos.

Este tipo de prueba es útil al principio de un programa de testeo para asegurar que la plataforma y la segmentación funcionan correctamente antes de ejecutar tests más complejos.

Test de funciones

Los tests de funciones se enfocan en evaluar nuevas funcionalidades o características dentro de un producto digital.

En lugar de comparar solo elementos visuales o de contenido, este tipo de test analiza cómo diferentes versiones de una función (por ejemplo, un nuevo filtro de búsqueda, una opción de personalización o un flujo de checkout) afectan el comportamiento del usuario.

Esto es especialmente común en productos tecnológicos, apps y plataformas SaaS donde introducir o modificar funciones puede tener un gran impacto en métricas clave como retención, interacción o conversión.

| Tipo de test | Qué compara | Objetivo principal |

| Test A/B clásico | Dos versiones de un elemento | Identificar qué versión funciona mejor |

| Split Test | Variantes completas de páginas o estructuras | Comparar experiencias distintas |

| Multivariante | Combinaciones de múltiples elementos | Ver interacción entre varios cambios |

| Multi-Armed Bandit | Asignación dinámica de tráfico | Maximizar rendimiento durante el test |

| Test A/A | Dos versiones idénticas | Verificar la integridad de la herramienta |

| Test de funciones | Funcionalidades o características | Medir impacto de nuevos features |

Ventajas de aplicar test A/B en marketing digital

Aplicar tests A/B en marketing digital permite optimizar estrategias de forma continua y con menor riesgo. En lugar de realizar cambios basados en suposiciones, este tipo de pruebas ofrece evidencia real sobre el comportamiento de los usuarios, lo que ayuda a identificar qué mensajes, diseños o formatos funcionan mejor. Gracias a ello, las marcas pueden mejorar sus resultados sin necesidad de aumentar la inversión, maximizando el rendimiento de cada acción y optimizando el retorno de la inversión (ROI).

Además, los tests A/B fomentan una cultura de experimentación y mejora constante. Cada prueba genera aprendizajes valiosos que pueden aplicarse a futuras campañas, contribuyendo a una toma de decisiones más estratégica y alineada con los objetivos del negocio.

A largo plazo, esta metodología no solo incrementa las conversiones, sino que también mejora la experiencia del usuario, refuerza la confianza en la marca y permite construir estrategias de marketing más sólidas, eficientes y escalables.

- Reducción del riesgo en la toma de decisiones

- Mayor retorno de inversión (ROI)

- Segmentación y personalización más efectivas

- Aprendizaje continuo y cultura del dato

Por qué los test A/B son esenciales en cualquier estrategia digital

Los tests A/B se han convertido en un pilar fundamental del marketing digital moderno porque permiten optimizar estrategias basándose en datos reales, reducir el margen de error y mejorar de forma continua los resultados. Gracias a este enfoque, las marcas pueden entender mejor a sus usuarios, tomar decisiones más acertadas y maximizar el impacto de cada acción, desde una simple landing page hasta campañas publicitarias complejas.

Si quieres implementar tests A/B de forma estratégica y sacar el máximo partido a tus campañas digitales, en NeoAttack te ayudamos a definir, ejecutar y analizar experimentos orientados a resultados. Contacta con nuestro equipo y empieza a convertir los datos en decisiones que impulsen el crecimiento de tu negocio.